Conversa con le tue App grazie a SiriKit

25 Ottobre 2016

Al giorno d’oggi gli assistenti digitali sono sempre più presenti nelle nostre vite, da Siri di Apple, passando per Cortana di Microsoft e VIV, fino al neonato Google Assistant. Tutti abbiamo provato almeno una volta a ottenere indicazioni stradali oppure a salvare appuntamenti pronunciando la frase chiave “Ehi Siri” oppure “Ok Google”, e abbiamo tentato di far emergere una personalità dai nostri assistenti preferiti attraverso delle battute, spesso trovandoli impreparati. Proprio per questo sembra che le più grandi aziende tecnologiche stiano pensando di investire nel campo della creatività ingaggiando attori e comici per proiettarci verso un futuro in cui questi strumenti avranno personalità più “calde” e quindi più umane.

Con l’avvento di iOS10, Apple apre Siri al mondo degli sviluppatori. Siri è l’assistente intelligente di Apple che aiuta chi lo utilizza a sfruttare le funzionalità del dispositivo mobile attraverso l’uso di comandi vocali. Questo sistema è nato anche per facilitare ricerche web senza dover effettivamente digitare, tramite tastiera, una query su un motore di ricerca o inviare messaggi. Grazie a queste funzionalità Siri risulta utile, ma a oggi non costituisce un’opportunità di business per le aziende che sviluppano applicazioni iOS. Per tali motivi Apple ha deciso di introdurre SiriKit, una piattaforma software espandibile da implementazioni di terze parti.

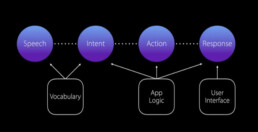

Grazie a SiriKit gli sviluppatori saranno in grado di aggiungere una nuova dimensione interattiva ai propri prodotti, quella vocale. Sarà possibile definire dei comandi attraverso i quali le applicazioni potranno essere interrogate da Siri. Lo scambio di informazioni tra Siri e le app che utilizzano SiriKit dovrà essere supportato dall’architettura illustrata nella seguente figura.

Mango Mobile Agency - sviluppo app

Gli elementi colorati in figura rappresentano il flusso di interazione che gli ingegneri di Apple hanno sintetizzato nel modello architetturale illustrato, composto da quattro fasi:

- Speech: rappresenta la parte in cui l’utente risveglia Siri, il dispositivo in questo caso percepisce un segnale audio.

- Intent: il segnale audio viene tradotto in una struttura dati.

- Action: in seguito all’analisi semantica effettuata sulla struttura dati, si seleziona un’azione che viene eseguita immediatamente da Siri.

- Response: Siri fornisce una risposta che rappresenta il risultato dell’esecuzione dell’azione scelta.

Grazie alle funzionalità che Apple fornisce nativamente per supportare queste fasi, gli sviluppatori possono concentrarsi solamente sulla personalizzazione di Siri per la loro App, tramite l’implementazione dei moduli Vocabulary, App Logic e User Interface, che consentiranno di rendere completa l’esperienza vocale dell’utilizzo delle loro applicazioni.

Una prima personalizzazione viene fornita tramite Vocabulary, in particolare quando Siri riceve un comando, durante la fase di Speech, e cerca di tradurlo per la fase di Intent: in primo luogo viene verificato se questo è presente nella base dati del sistema, se così non è allora Siri cerca una corrispondenza fra i comandi del vocabolario della specifica App. Il modulo Vocabulary permette dunque di specificare le parole chiave che consentono a Siri di categorizzare in maniera corretta, nelle prime due fasi dell’analisi della frase pronunciata dall’utente, le varie parti che compongono un intero comando.

Successivamente, attraverso l’implementazione dell’App Logic, le App possono elaborare l’Intent, ossia una particolare struttura dati, che Siri ha costruito elaborando l’audio ricevuto, ed eseguire così l’azione desiderata dall’utente.Una volta fatto questo l’applicazione può fornire una risposta a Siri in modo da visualizzare la Response tramite un’interfaccia grafica che è possibile personalizzare.

La possibilità di mostrare un’interfaccia grafica, attraverso delle Intents UI Extension, integrando quella nativa di Siri con cui l’utente sta interagendo, rappresenta un’opportunità aggiuntiva attraverso la quale gli sviluppatori, e in particolare le aziende, possono pensare di promuovere nuove forme di interazione ad hoc per le loro app native.

A noi di Mango Mobile Solutions viene naturale immaginare come i nostri prodotti offriranno nuove forme di interazione grazie all’innovazione tecnologica. Perciò ai visitatori dei nostri clienti Teatro basterà pronunciare:

“Ehi Siri, a che ora va in scena Filippo Timi al Teatro Parenti questa sera?”

per ottenere un servizio ancora più performante. Ma cosa succederà “under the hood”?

Siri interpreterà il messaggio e, tramite il vocabolario, costruirà un Intent da inviare all’applicazione Teatro Parenti. A questo punto l’Intent verrà risolto dall’app in un’azione che cerca di trovare lo spettacolo in cui questa sera recita Filippo Timi: nel caso in cui l’esecuzione di questa azione sia positiva, attraverso una grafica dedicata Siri mostrerà all’utente la scheda dello spettacolo; in caso contrario Siri risponderà:

“Questa sera non ci sono spettacoli di Filippo Timi”

mostrando all’utente le informazioni del prossimo spettacolo in scena.

SiriKit apre le porte a servizi (offerti dalle relative app) rendendoli accessibili a chi non riesce ad utilizzare le mani o distogliere lo sguardo, mentre si guida, mentre si cucina, mentre si plasma un’opera d’arte, mentre si vive la propria vita di tutti i giorni con una disabilità. E se da una parte si abilita questa nuova forma di interazione per le app, dall’altra si rendono ancora più consci e utili i nostri assistenti digitali, capaci di ricondurci sempre meno ad una ricerca sul web ma dandoci la risposta che attendevamo.

Condividi su